.运动特征

作者姓名:王瀚漓 职称:教授 电子邮件:hanliwang@tongji.edu.cn

运动特征(motion feature) 是用来描述视频中运动信息的一种方法,属于计算机视觉中视觉特征的一个子类,被广泛应用于视频内容检索、智能监控、人机交互等领域。

简史介绍 21世纪初信息技术飞速发展,随着视频监控、手持拍照设备等逐步普及,在互联网上产生海量的视频,视频内容理解技术应运而生。为了使用计算机技术自动分析视频内容,可以使用声音特征和视觉特征对视频内容进行描述。视觉特征包括色彩特征、纹理特征、形状特征、运动特征和位置特征。对于情感分析、人类行为识别、事件分析等应用场景,视频中物体的运动信息对识别的准确率产生重要的影响,所以运动特征具有比其他视觉特征更强的描述能力.

视频中的运动信息主要由两类因素引起,包括:视频中物体的运动和拍摄该视频的摄像机的运动。在情感分析、人类行为识别、事件分析等应用场景中,对视频内容分析有效的信息是视频中物体的运动信息,而摄像机的运动信息可能会对视频内容理解产生干扰。所以在设计特征的时候,运动特征应该主要关注视频中物体的运动信息,并且尽量消除由于摄像机运动导致的干扰信息。

运动特征的发展主要经历以下三个阶段。第一个阶段是基于时空域的运动特征,该类特征大部分通过将二维的图像特征扩展到三维空间而产生。第二个阶段是基于运动轨迹的特征,该类特征在跟踪运动点的基础上形成运动轨迹特征,能够描述连续的运动信息。第三个阶段是基于机器学习的特征,该类特征使用深度神经网络技术描述视频中的运动信息。根据设计运动特征时所使用技术的不同,也可以将运动特征分为基于人工设计的运动特征和基于机器学习的运动特征。

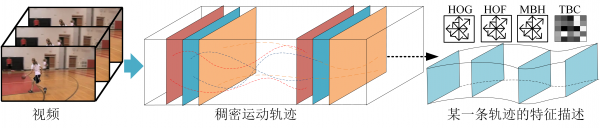

基本内容 与图片相比,视频具有数据维度更高、内容更复杂的特点,所以视频内容识别比图像识别更困难。在早期的运动特征中,2005年提出的时空兴趣点(Spatial-Temporal Interesting Points)特征[1]是应用最广泛的特征之一。该方法将二维哈里斯(Harris)点检测扩展到三维空间,在时域和空域中检测具有显著变化的区域。除时空兴趣点特征外,还出现一系列将二维特征扩展到时空域的特征,如:2007年提出的三维尺度不变特征变换 (3D Scale Invariant Feature Transform)[2]将二维的尺度不变特征变换(Scale Invariant Feature Transform)特征扩展到三维空间,使得该特征可以表示时空之间的关联;2008年提出的基于Hessian矩阵的时空兴趣点检测(Hessian-based Spatio-Temporal Interest Point) 将加速鲁棒特征(Speeded Up Robust Features)扩展到三维空间;2009年提出的局部三元模式(Local Trinary Patterns)特征[4]将局部二值模式(Local Binary Patterns)特征扩展到时间域。与上述方法不同,在2013年提出的稠密轨迹(Dense Trajectories)[5]使用稠密采样的方法选取被跟踪的点,在多尺度空间中通过光流跟踪点的运动轨迹。图1是基于稠密运动轨迹特征的示意图;一般可以使用五种局部特征描述稠密轨迹,包括:轨迹(Trajectory)特征 [5]、方向梯度直方图(Histograms of Oriented Gradients, HOG)特征[6]、光流直方图 (Histograms of Optical Flow, HOF)[7] 特征、运动边界直方图(Motion Boundary Histograms, MBH)特征[8]、基于轨迹的协方差(Trajectory Based Covariance, TBC)特征[9]。其中,轨迹特征描述被跟踪点的运动偏移,该特征先计算被跟踪点在前后帧之间的水平和垂直方向的偏移量,然后通过组合轨迹中点的偏移量形成该轨迹的描述向量;方向梯度直方图特征表示外观的统计信息,该特征先计算区域内的梯度,然后分块统计直方图信息;光流直方图特征表示局部的运动信息,该特征分块统计光流的运动方向和梯度;运动边界直方图特征表示视频中物体运动边界的统计信息,并且能够减轻摄像机运动导致的干扰,该特征将光流分为水平和垂直两部分,然后分别量化这两个部分的水平和垂直方向的一阶导数;与基于直方图的运动特征不同,基于轨迹的协方差特征沿运动轨迹计算多个运动变量的协方差矩阵,描述这些运动变量之间的关联信息。之后有很多对稠密轨迹方法的改进技术,如:消除摄像机运动干扰的技术[10],费舍尔向量(Fisher Vector)编码技术等。

除上述人工设计的特征外,基于机器学习的运动特征逐渐成为研究热点。虽然卷积神经网络(Convolutional Neural Networks)特征在图像识别领域取得了令人瞩目的成绩,但是该方法在视频内容理解领域的研究进展相对图像识别领域更缓慢。这主要是因为视频数据的维度比图像高,如果使用深层的神经网络结构,在训练网络的过程中容易出现过拟合现象。2010年提出的基于卷积学习(Convolutional Learning)的时空特征[11]从视频中学习潜在的特征描述,在多级结构下提取对运动敏感的信息,该特征能够同时表示静态和动态的内容。2013年提出的三维卷积神经网络(3D Convolutional Neural Networks)特征[12]是二维卷积神经网络在时空域上的扩展,该模型从输入的视频帧中产生多个通道的信息,通过组合这些信息产生最终的特征表示。2014年提出的两路流卷积网络(Two-Stream Convolutional Networks)特征[13]使用空间流卷积网络和时间流卷积网络共同描述视频中的运动信息,将视频帧作为空间流卷积网络的输入,将相邻帧之间的光流作为时间流卷积网络的输入。如图2所示,每一个网络包含5个卷积层和2个全连接层,分别使用一个深度卷积神经网络实现每一路流计算,然后使用后融合技术将这两路流输出的分数进行组合。在2015年提出的深度三维卷积网络(Deep 3-Dimensional Convolutional Networks)特征[14]使用深度的三维卷积神经网络描述视频中的外观和运动信息,在所有层使用3×3×3的卷积核能够得到最好的实验结果。在2016年提出的两路流网络融合(Two-Stream Network Fusion)特征 [15] 是两路流卷积网络特征的扩展。为了解决后融合技术导致的时间域特征和空间域特征分离的问题,该特征在卷积神经网络内部融合时间域和空间域的信息,使用VGG-16网络模型,包含13个卷积层和3个全连接层。时间分段网络(Temporal Segment Networks)[16]特征也是两路流卷积网络特征的扩展,该特征使用稀疏时间采样策略从一个长视频中提取短的视频片段,使得该特征可以在一个完整视频的层次上建模长距离的时间结构。

发展趋势 视频运动信息具有:维度高、复杂、多变等特点,这使得单个特征很难较好地表示运动信息。使用多特征融合技术组合多种类型的运动特征可以更好地描述视频信息,所以多特征融合是未来的一个发展趋势。未来的另一个发展趋势是计算机自动根据视频内容学习运动特征。随着硬件性能逐步提升,计算机拥有更强大的运算能力,使得它能够自主的从视频内容中分析运动特征,而不需要特别地针对某些场景设计运动特征。当计算机拥有足够强大的运算能力的时候,它将能够从海量的视频数据中学习运动特征,最终实现自主理解视频内容。

参考文献

[1] Laptev I. On Space-Time Interest Points[J]. International Journal of Computer Vision, 2005, 64(2-3):107-123.

[2] Scovanner P, Ali S, Shah M. A 3-dimensional sift descriptor and its application to action recognition[C]// 2007 ACM international conference on Multimedia (ACM MM’07).

[3] Willems G, Tuytelaars T, Van Gool L. An efficient dense and scale-invariant spatio-temporal interest point detector[C]// 2008 European Conference on Computer Vision (ECCV’08).

[4] Yeffet L, Wolf L. Local trinary patterns for human action recognition[C]// 2009 IEEE International Conference on Computer Vision (ICCV’09).

[5] Wang H, Kläser A, Schmid C, et al. Dense Trajectories and Motion Boundary Descriptors for Action Recognition[J]. International Journal of Computer Vision, 2013, 103(1):60-79.

[6] Dalal N, Triggs B. Histograms of oriented gradients for human detection[C]// 2005 IEEE Conference on Computer Vision and Pattern Recognition (CVPR'05).

[7] Laptev I, Marszalek M, Schmid C, et al. Learning realistic human actions from movies[C]// 2008 IEEE Conference on Computer Vision and Pattern Recognition (CVPR’08).

[8] Dalal N, Triggs B, Schmid C. Human detection using oriented histograms of flow and appearance[C]// 2006 European Conference on Computer Vision (ECCV’06).

[9] Wang H, Yi Y, Wu J. Human action recognition with trajectory based covariance descriptor in unconstrained videos[C]// 2015 ACM international conference on Multimedia (ACM MM’15).

[10] Wang H, Oneata D, Verbeek J, et al. A robust and efficient video representation for action recognition[J]. International Journal of Computer Vision, 2016: 119(3):219–238.

[11] Taylor G W, Fergus R, LeCun Y, et al. Convolutional learning of spatio-temporal features[C]// 2010 European Conference on Computer Vision (ECCV’10).

[12] Ji S, Xu W, Yang M, et al. 3D convolutional neural networks for human action recognition[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2013, 35(1): 221-231.

[13] Annane D, Chevrolet J C, Chevret S, et al. Two-Stream Convolutional Networks for Action Recognition in Videos[C]. 2014 Advances in Neural Information Processing Systems (NIPS’14). [14] Tran D, Bourdev L, Fergus R, et al. Learning spatiotemporal features with 3d convolutional networks[C]// 2015 IEEE International Conference on Computer Vision (ICCV’15).

[15] Feichtenhofer C, Pinz A, Zisserman A. Convolutional Two-Stream Network Fusion for Video Action Recognition[C]. 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR'16).

[16] Wang L, Xiong Y, Wang Z, et al. Temporal segment networks: towards good practices for deep action recognition[C]// 2016 European Conference on Computer Vision (ECCV’16).